Termin big data jest obecnie bardzo popularny – zetknął się z nim zapewne każdy, nawet jeśli nie interesuje się ani nie zajmuje tą tematyką na co dzień. Pojęcie to ciągle nie jest w pełni rozumiane, bowiem określa się nim niesłusznie każdy duży zbiór danych.

Tymczasem big data pojawia się dopiero tam, gdzie tradycyjna eksploracja danych (data mining) nie jest w stanie wyszukać ukrytych w tych danych znaczeń i wzorców. Wynika to z faktu, że znakomita większość gromadzonych obecnie danych jest nieustrukturyzowana (nie jest przechowywana w formie uporządkowanych tabel), wymaga przetwarzania w czasie rzeczywistym lub jest po prostu bardzo duża, wobec czego nie można do nich zastosować relacyjnych baz danych czy hurtowni danych.

Równolegle jednak do rosnącej popularności big data rośnie także świadomość problemu oraz zainteresowanie tworzeniem i rozwijaniem narzędzi, algorytmów i technologii zdolnych „udźwignąć” big data. Wymienić tutaj można np. Hadoop, MapReduce czy bazy danych NoSQL. Technologie te stanowią centralną część ram oprogramowania open-source, co ułatwia przetwarzanie ogromnych zbiorów na systemach klastrowych.

Same narzędzia jednak nie wystarczą. Fascynacja trendem big data zrodziła zapotrzebowanie na odpowiednio przygotowanych analityków, którzy będą umieli w pełni wykorzystać możliwości ukryte w tych ogromnych zbiorach danych poprzez wyciąganie odpowiednich wniosków – dopiero bowiem wtedy zgromadzone dane stają się wartościowe. Analityków tych określa się mianem data scientists, zaś całą naukę – data science. O ogromnym znaczeniu big data oraz samych data scientists świadczy chociażby fakt, że zawód ten okrzyknięty został przez „Harvard Business Review” najbardziej pożądanym zawodem XXI wieku. Co więcej, Wielka Brytania uznała badania nad Big Data za jeden z ośmiu strategicznych kierunków rozwoju nowych technologii, a rząd USA przeznaczył w 2012 roku 200 milionów dolarów na badania i rozwój nowych inicjatyw big data.

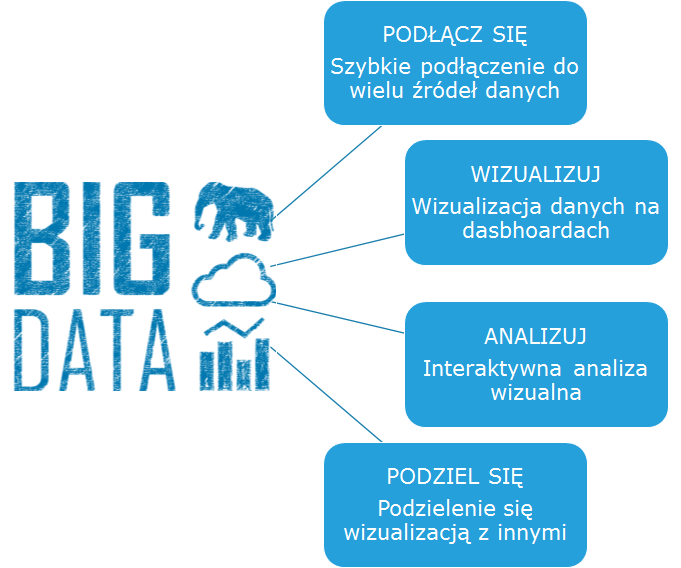

Big Data w liczbach

Podobnych wniosków dostarczają też dane statystyczne i prognozy na temat big data i całego związanego z nimi rynku. Świat produkuje coraz większą ilość danych. Każdego dnia wysyłanych jest ponad 500 milionów tweetów, a miesięcznie na Facebooku pojawia się ponad 30 miliardów nowych wpisów – każdy zawierający informacje o zachowaniach i upodobaniach konsumentów. W każdej godzinie Walmart przetwarza milion transakcji swoich klientów. Eric Schmidt z Google twierdzi, że obecnie co 2 dni wytwarzamy tyle danych, ile cała ludzkość wyprodukowała od początku cywilizacji do początku XXI wieku, a dane na świecie co najmniej podwajają się co 2 lata. Jak podano na konferencji Hadoop Summit 2014 w San Jose w Kalifornii, szacuje się, że obecnie na świecie jest 3,2 zetabajtów danych (1 zetabajt to miliard terabajtów), a do 2020 roku ilość ta urośnie do 40 zetabajtów. Interesujący jest fakt, że ponad 70% tych danych generowana jest przez jednostki, natomiast przedsiębiorstwa odpowiedzialne są za przechowywanie i zarządzanie 80% z nich. Warto również dodać, że do 2020 roku około jedna trzecia wszystkich danych będzie przechowywana bądź przetwarzana w chmurze.

Mówiąc zaś językiem wymiernych korzyści, wystarczy nadmienić, nawiązując do raportu Digital Trends 2013, opracowanego przez specjalistów z Deloitte i Allegro, że globalny rynek big data – a więc wszelkie technologie, sprzęt, oprogramowanie, jak i usługi z nimi związane – wart będzie w 2015 roku prawie 50 miliardów dolarów, z prognozowanym wzrostem 40% rok-do-roku.

Coraz częściej zresztą słyszymy o fascynujących przykładach wykorzystania big data w różnych branżach. Jako przykład posłużyć może sytuacja Tesco w Malezji, które miało problem z odbudowaniem lojalności wśród klientów. By jak najlepiej spersonalizować ofertę, rozpoczęli analizy trendów rynkowych, danych z kart lojalnościowych, które prezentowały jak, kiedy i co kupowali ich klienci. W efekcie udało im się reaktywować 3000 klientów, lojalność klientów wzrosła o 30%. Z kolei T-mobile w USA, dzięki analizie danych z systemów CRM i mediów społecznościowych, zmniejszył o 50% liczbę rezygnacji klientów z usług firmy. Sięgając do przykładów z europejskiego podwórka, warto między innymi wspomnieć o sukcesie platformy Tipp24 AG do obstawiania zakładów w loteriach. Dzięki analizie miliardów transakcji i tysięcy czynników determinujących przyzwyczajenia swoich klientów udało się firmie spersonalizować komunikację marketingową w czasie rzeczywistym oraz skrócić aż o 90% czas potrzebny na budowanie modeli predykcyjnych przyszłych zachowań konsumentów.

Kolejnym i chyba jednym z najbardziej medialnych przykładów zastosowania big data w dosyć rewolucyjny, nieoczywisty sposób jest przygotowanie produkcji serialu „House of Cards”. Firma Netflix zrealizowała produkcję serialu w oparciu o analizę wzorców zachowań, przyzwyczajeń i gustów swoich klientów. Serial odniósł ogromny sukces, ale producenci byli o nim przekonani, zanim ktokolwiek na planie zdążył krzyknąć pierwsze „Akcja!”.

Big Data a wizualizacja danych

O co więc tak naprawdę chodzi w analityce big data? O dostrzeganie tego, co niewidoczne w niezliczonej ilości danych z chociażby takich źródeł, jak portale społecznościowe, filmy, różnego rodzaju czujniki, kamery, satelity czy transakcje zakupowe. O zhumanizowanie tych danych i uczynienie ich bardziej zrozumiałymi dla innych użytkowników – zatem big data to także nowe wyzwanie dla dziedziny wizualizacji danych. Mimo że zmienia się ona wraz z rozwojem coraz to nowych technologii, ciągle musi przestrzegać starych zasad – wizualizacje muszą być dobrze zaprojektowane, łatwe w użyciu, zrozumiałe, przejrzyste i dostarczać odpowiednich informacji. W stosunku do big data standardowe wykresy czy grafy nie są już wystarczającymi narzędziami, bowiem ograniczają się tylko do jednego bądź dwóch wymiarów i nie są w stanie objąć całej „głębi” ogromnych zbiorów danych. Pojawiła się potrzeba opracowania i rozwijania solidnych, interaktywnych narzędzi, które będą funkcjonalne i „aktualizowalne” – zdolne do przetwarzania danych w czasie rzeczywistym. W żargonie mówi się o 3xV – Volume, Variety, Velocity – i to właśnie z tymi 3 aspektami: dużą objętością, różnorodnością czy też złożonością, a także przetwarzaniem w czasie rzeczywistym muszą poradzić sobie nowe metody.

Infografika, Dashboard, Mapa

Infografiki, które w ostatnim czasie stały się szczególnie popularne, są doskonałym środkiem, by przedstawić złożone problemy w sposób, który będzie zrozumiały dla każdego użytkownika. Infografiki są zwykle starannie przygotowane w formie plakatu bądź prezentacji i w przejrzysty sposób obejmują wieloaspektowe, wielowymiarowe problemy. Ich dużą wadą jednak jest fakt, że zwykle są one stałe w czasie, a zatem ograniczone są możliwości wykorzystania ich w interaktywnej analizie danych. Co więcej, ich autorzy raczej skupiają się na aspektach estetycznych, a nie na danych i wnioskach, które z nich płyną. Z infografikami należy więc uważać.

Dashboardy łączą wiele aspektów danych na jednym ekranie i najczęściej pozwalają odbiorcy na interakcję. Są przeznaczone dla grona przeszkolonych odbiorców. Więcej o tego typu raportach biznesowych dowiesz się z artykułu Co to jest dashboard?.

Mapy są idealne do przedstawiania danych zróżnicowanych geograficznie, a ich popularność stale rośnie dzięki coraz większej ilości map i danych dostępnych publicznie.

Warto tutaj odnotować, że znani dostawcy narzędzi business intelligence, jak IBM, Cognos czy SAS, w dalszym ciągu są dużymi graczami na dynamicznie rozwijającym się rynku odkrywania danych, wizualizacji i umiejętności wyciągania właściwych wniosków, lecz ich udział w tym rynku maleje. Obecnie firmy nie muszą wydawać ogromnych kwot, by poradzić sobie z wizualizacją danych, bowiem narzędzia temu dedykowane stają się nie tylko coraz powszechniej dostępne, lecz także proste w użytkowaniu, co jest szczególnie ważne dla użytkowników spoza branży IT. Jako przykład mogą posłużyć Vizify, D3.js, Visual.ly, GNU R i wiele innych.

Najlepszym podsumowaniem będzie chyba wniosek, że problem big data jest nierozerwalnie związany z wizualizacją danych, która obok coraz to lepszych narzędzi hardware’owych i software’owych stanowi jeden filarów analityki big data.

Jak zmienia się świat analityki biznesowej? – Tableau, QlikView, Microsoft PowerBI

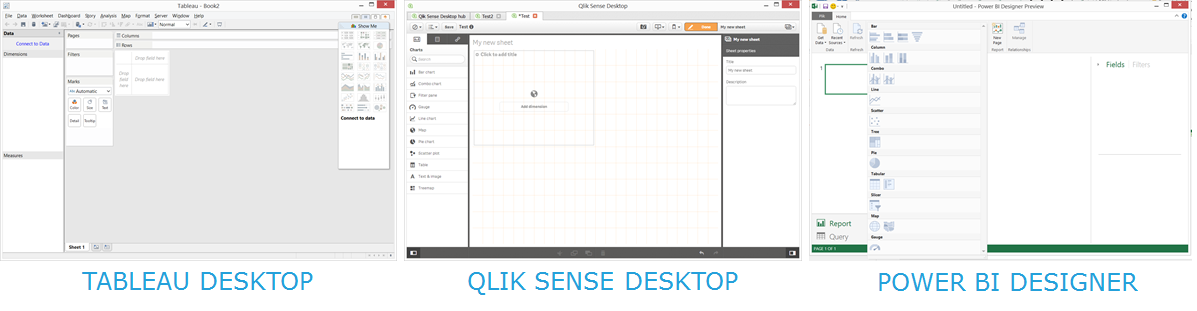

Podążając za wymaganiami klientów, dostawcy programów zmienili paradygmat, uznając, że centralną postacią w kwestii przetwarzania danych i ich obróbki powinien być każdy zwykły użytkownik, a nie tylko wyspecjalizowane zespoły działów IT. Każda szanująca się firma software’owa zaczęła więc – z różnym skutkiem – przygotowywać narzędzia, które pozwolą podłączyć się do źródła danych, zaprezentować je poprzez ich wizualizację, przeanalizować w interaktywny sposób i udostępnić innym pracownikom. Te 4 filary łączą produkty tworzone m.in. przez Tableau (Tableau Desktop), QlikView (QlikSense Desktop) i Microsoft (Power BI Designer).

Możliwości wizualizacyjne każdego z tych programów omówimy szczegółowo w kolejnym artykule, warto jednak podkreślić jedno – przyszłość analityki biznesowej nierozłącznie wiąże się z wizualizacją danych i dashboardami, a umiejętność analizy danych z pomocą jednego z tych programów będzie kluczem do rozwoju własnego i organizacji, w której pracujemy.

Co łączy eBay i Allegro?Po pierwsze, są to dwie firmy o międzynarodowym zasięgu, przetwarzające olbrzymią ilość danych transakcyjnych i webowych. Po drugie, obie firmy sięgnęły po Tableau, aby oddać inicjatywę swoim analitykom i pozwolić im zobaczyć dane. Jak powiedział Gary Dougan, szef BI w eBay, który udostępnił Tableau Desktop wszystkim pracownikom: „Tableau przynosi wartość ukrytą w danych do niemal każdego pracownika w eBay. Zostało świetnie przyjęte przez użytkowników, a jego użycie podwaja się co sześć miesięcy. To pozwala pracownikom na eksplorację big data w eBay i coraz mocniej wspiera naszą strategię.” |

Infografika Big Data

Jako ciekawostkę zamieszczamy poniżej infografikę, prezentującą nieco więcej danych statystycznych na temat big data.

Źródło: https://hrboss.com/blog/2014-02-03/what-big-data-infographic